编者按:第30届国际人工智能联合大会 IJCAI 2021 于8月19日-26日在线上正式召开。此次大会共收到4204篇投稿,其中587篇论文被接收,接收率为13.9%。在本届会议中,微软亚洲研究院也有多篇论文入选,今天我们精选了其中的5篇来为大家进行简要介绍。欢迎大家积极参与文末的投****活动,我们将邀请大家最感兴趣的论文的作者进行深度讲解,与大家线上交流!

01 利用独立性的优势函数估计方法

论文链接:

https://www.ijcai.org/proceedings/2021/0461.pdf

在强化学习中,优势函数 (advantage function) 普遍采用蒙特卡洛 (MC)、时间差分 (TD),以及一种将前两者结合的优势函数估计算法(GAE) 等进行估计,而这些算法都存在方差较高的问题。因此,微软亚洲研究院的研究员们首次提出通过利用环境中存在于当前动作和未来状态之间的独立性,来降低优势函数估计中的方差。

在该方法中,存在于环境中的独立性可以用来构建一个基于重要性采样 (importance sampling) 的优势函数估计量。该估计量可以忽略未来无关的部分奖励,从而减小估计中的方差。为了进一步减少优势函数估计的方差,研究员们把该估计量和已有的蒙特卡洛估计量进行融合,并将最终的优势函数估计量命名为 IAE (Independence-aware Advantage Estimation)。实验结果表明,在策略优化算法中,IAE 与现有的优势函数估计方法 (GAE, MC) 相比,达到了更高的样本利用率。

事实上,现有方法往往先估计值函数 Q(s,a) 和 V(s),再将二者相减,进而估计优势函数。但当值函数覆盖的时间范围较大时,估计值函数就需要考虑未来较长时间内的总奖励,因此导致了高方差的问题。

当环境中存在独立性时,优势函数的估计就不需要考虑环境中的部分奖励,从而使得估计中的方差减小。举个例子:假设智能体当前的任务是打乒乓球,在该环境下,智能体每赢得一分或输掉一分后,游戏的状态都会被重新设置到起始状态,并继续进行下一轮游戏。当对智能体每一个动作的优势函数进行估计时,由于智能体每个动作的影响都被限制在当前回合内,所以下一轮及之后的奖励实质上不影响优势函数的估计。

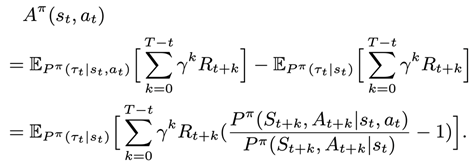

上述例子表明,如果执行当前的动作不影响未来某些状态的概率,那么这些未来状态上的奖励在估计优势函数时就可以被忽略。研究员们对上述观察进行了概括和抽象,并提出了基于重要性采样的优势函数估计量。下面给出的是基于重要性采样推导出来的该估计量的形式:

此公式证明了如下的估计量是优势函数的无偏估计量:

在后续推导中,研究员们进一步将上述基于重要性采样的估计量与基于蒙特卡洛的优势函数估计量进行结合,并通过优化结合后估计量的方差,使优势函数估计的方差更小。同时,研究员们将组合后的优势函数估计量命名为 IAE,并在实验中测量了 IAE 的估计性能。最后,研究员们还提出了上述公式中重要性采样的概率比值的估计方法,并且还利用其对该概率比值进行了准确的估计。

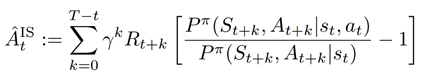

在 tabular 设置下,研究员们构建了多种包含3个状态的马尔可夫决策过程 (MDP),并且在这些设置中包含了不同的转移函数设置和不同的奖励设置。研究员们比较了 IAE、蒙特卡洛、重要性采样三种优势函数估计量在不同设置下的标准差,结果见表1。实验结果表明,IAE 的估计量的标准差显著小于蒙特卡洛和重要性采样的估计量的标准差。

表1:不同设置下 IAE、MC、IS 的标准差

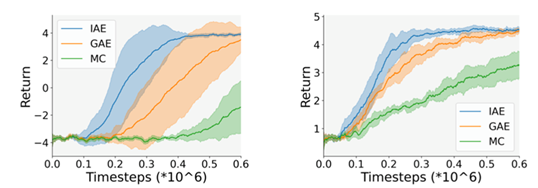

为了验证 IAE 在策略优化中的作用,研究员们将 IAE、蒙特卡洛、GAE 分别作为 PPO 算法中的优势函数估计方法,使用 PPO 算法进行策略优化,并观察不同优势函数估计方法在策略优化中的性能。该实验使用高维图像作为状态,即智能体的策略和优势函数的估计均只使用图像输入。PPO 算法在不同优势函数估计方法下的训练曲线图1,两幅图对应于两种不同的奖励设置。实验结果表明,IAE 作为优势函数估计算法时,策略优化过程的样本利用率更高。

图1:PPO 算法在不同优势函数估计方法下的训练曲线

02 面向合作与非合作任务的多智能体强化学习方法MFVFD

论文链接:

https://www.ijcai.org/proceedings/2021/0070.pdf

多智能体强化学习(Multi-agent Reinforcement Learning, MARL) 有望帮助解决各种现实世界中的问题。然而,追求有效的MARL 面临着两大挑战:部分可观察性和可扩展性限制。为了应对这两大挑战,并使得 MARL 适用于竞争任务、合作任务以及混合任务,微软亚洲研究院和北京大学的研究员们在中心训练分散执行(Centralized Training with Decentralized Execution,CTDE)的框架下,从个体值函数分解 (Value Function Decomposition,VFD)的角度,结合平均场理论(Mean Field Theory,共同提出了一种新颖的多智能体 Q 学习方法——MFVFD。

正所谓“非宅是卜,唯邻是卜”,如果邻里和睦,则利人利己;而邻里不和,则多是非。也就是说,在多智能体系统中,个体不仅要考量最大化自身的利益,也要考量其临近智能体的行为对齐本身的影响。比如,在足球环境中,球员射门得分与否,除去依赖球员个体自身的射门能力之外,还会受到近邻智能体的影响,即优秀的队友与糟糕的对手会促进得分,而糟糕的队友和优秀的对手则会阻碍得分。

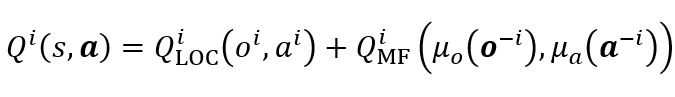

为了研究多智能体如何在既有合作又有竞争的环境下的表现,研究员们基于平均场理论将个体在多智能体系统中基于全局信息的动作值函数,近似为基于局部信息估计的个体动作值函数与基于近邻信息的平均场影响函数的和,公式如下:

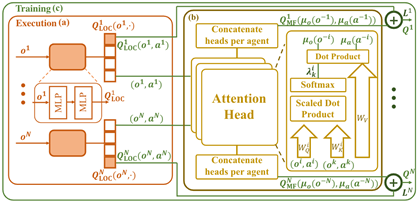

其中,Q_LOC^i 为基于局部信息的个体 i 的动作值函数,用于动作选择;Q_MF^i 为基于近邻信息的平均场影响函数,用于辅助对 Q_LOC^i 的估计。考虑到智能体不同近邻的重要性不同,所以研究员们使用注意力机制(Attention)建立了单体与近邻的权重 λ^i (o^i,o^k,a^i,a^k),并基于此计算带有重要性权重的近邻观测分布 μ_o (o^(-i) ) 和动作分布 μ_a (a^(-i) ) ,以构建平均场影响函数 Q_MF^i。

图2:MFVFD 网络结构图

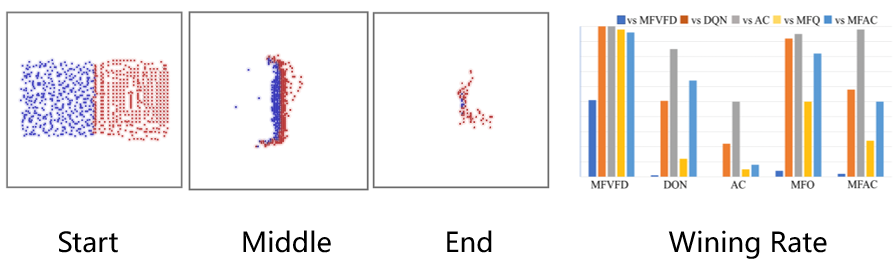

在主试验部分,研究员们选取了 MAgent Battle 任务,对 MFVFD 在具有大规模智能体且具有部分观测的限制下的性能进行了验证。在该任务中,红蓝双方各具有400个智能体,每个智能体具有局部观测,且无法通讯,其通过消灭敌人来获得奖励。由于每个智能体以优化各自的奖励为目标,所以单体会与同伴竞争杀敌数量,来获取更多的个人奖励。除此之外,单体还会与同伴配合避免被杀害,以消灭所有敌人获取更多的团队奖励。因此,这是一个合作和竞争混合的复杂任务。如图3所示,MFVFD(红色)与基线方法的(蓝色)相比,学会了更难的团体配合的围歼策略,取得了胜利。从对抗胜率上可以看出,MFVFD 在所有的基线方法中,几乎处于不败地位。

图3:MFVFD 与基线方法相比

此外,研究员们还选取了三个任务对 MFVFD 方法进行了理论分析,分别是:重复矩阵博弈任务----鹰鸽博弈与非单调合作博弈;合作导航任务----Cooperative Navigation;交通任务----Traffic Benchmark。从长远来看,MFVFD 在实际环境中能够有实际可行的研究价值。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。